1. GTX1050浮点运算简介

针对中低端显卡市场,消费者对GTX 1050的浮点运算性能尤为关注。浮点算术指以小数形式表现数据的计算过程,涉及精度与效率两大要素。因此,将GTX 1050的浮点实力呈现给广大消费者,无疑是他们所关心的主要议题之一。

全新设计的NVIDIA GP107-300(后更名为GTX1050)显卡,搭载Pascal架构及640个流处理器,基于16纳米制程打造。凭借其优越的浮点运算表现,此款显卡尤其适用于进行大规模的影像渲染和深层学习等需求较高的运算应用场景。

GTX1050凭借出色的浮点运算能力,足以满足普通用户生活及轻度游戏需求。在专业领域运用上,GTX1050亦有其用武之地,适用于对频点计算要求不高的特定情境。

2.浮点数与整数运算

计算机里,浮点数与整数为两类数据表现形式。前者可展示实数或分数值,后者仅表示整数。于实际操作中,浮点数常用于对高精准度要求或是小数表示的情况。

当采用NVIDIA GTX 1050执行浮点运算时,该处理器会依据实际计算需求,选用最适宜的数据类型进行处理。需要进行高度精准计算的任务,浮点数值能够更为精确地表达与应对。而若计算属于整型数据范畴或不涉及小数精度,则可优先考虑使用整数类型来执行操作。

在实践编程及运用环节,开发者需因地制宜地选用适宜的数据型态展开计算,从而将GTX1050特有的浮点运算效能得以极致展现。

3.浮点运算精度与性能

浮点运算精度乃评估计算机系统性能及精确度之重要指标。采用GTX1050进行运算时,其具备单精度(32位)与双精度(64位)等多样化精度模式。

单精度计算有助于提升运算效率及节省内存资源,适合于对精确度要求不甚严格的情况。相反,双精度计算具有更高的精度与稳定性优势,在科研、工控领域等精确度至关重要的环境下具有重要价值。

开发者应依据实际需要,确定最佳浮点精度选项,确保运算精确度的同时提升运行速度。此外,充分发挥GTX1050的并行处理优势,有助于增强系统整体效能。

4. GTX1050与深度学习中的浮点运算

近几年,深度学习技术的运用日益普及,对显卡的处理能力亦产生了猛烈需求。尤其是针对GTX1050这类主流显卡,更是在深度学习领域获得了大量的实际应用。

鉴于深度学习模型涵盖大量复杂的参数与体系架构且在训练和推理阶段需执行繁复的矩阵运算以及梯度更正操作,因此,借助GTX1050所具备的磅礴并行力及卓越的单精度性能,便可很好地应对训练小型深度学习模型这个挑战。

借助深度学习模型优化及GPU加速库应用,充分发掘GTX1050在深度学习领域的优势,实现更优异的训练结果与高效推断速度。

5. GTX1050在图形渲染中的应用

除了深度学习领域,GTX1050在3D图形处理上也表现卓越。图形渲染涉及众多元素,如矢量运算、纹理映射和光影效果等,对计算能力提出了较高要求。

GTX 1050凭借出色的图形渲染性能,被广泛运用于各类场景,包括游戏、设计绘制以及电影后期制作等方面。强大且价格合理的特性让它成为了业界优选的图形渲染解决方案之一。

开发者有能力通过深度优化图形渲染引擎及高效运用GPU并行运算优势来改善GTX1050在图像处理方面的性能表现,为广大用户带来更为流畅且逼真的视觉体验。

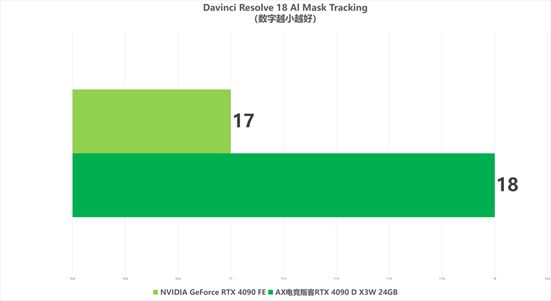

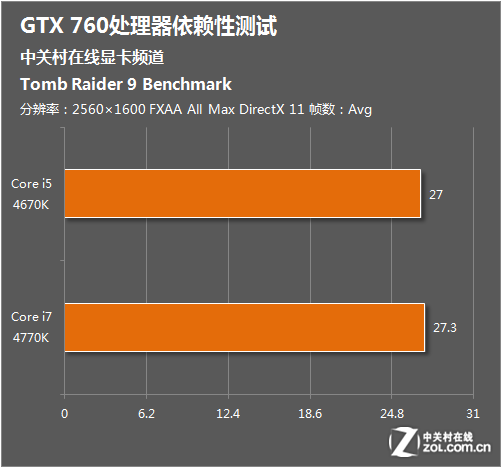

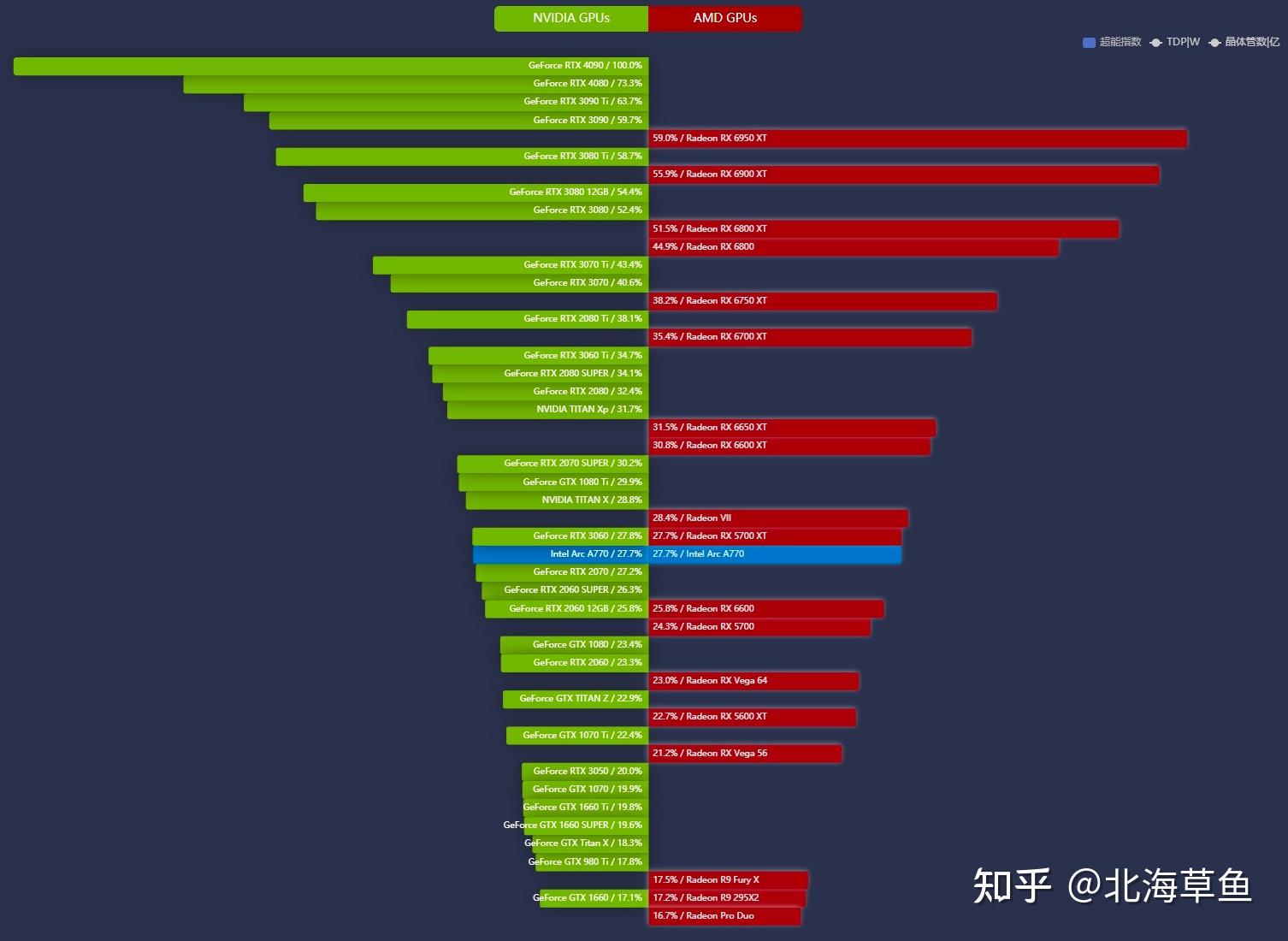

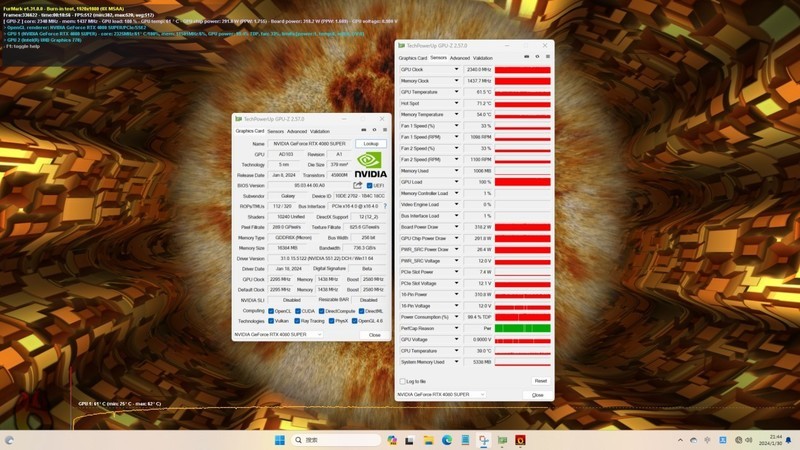

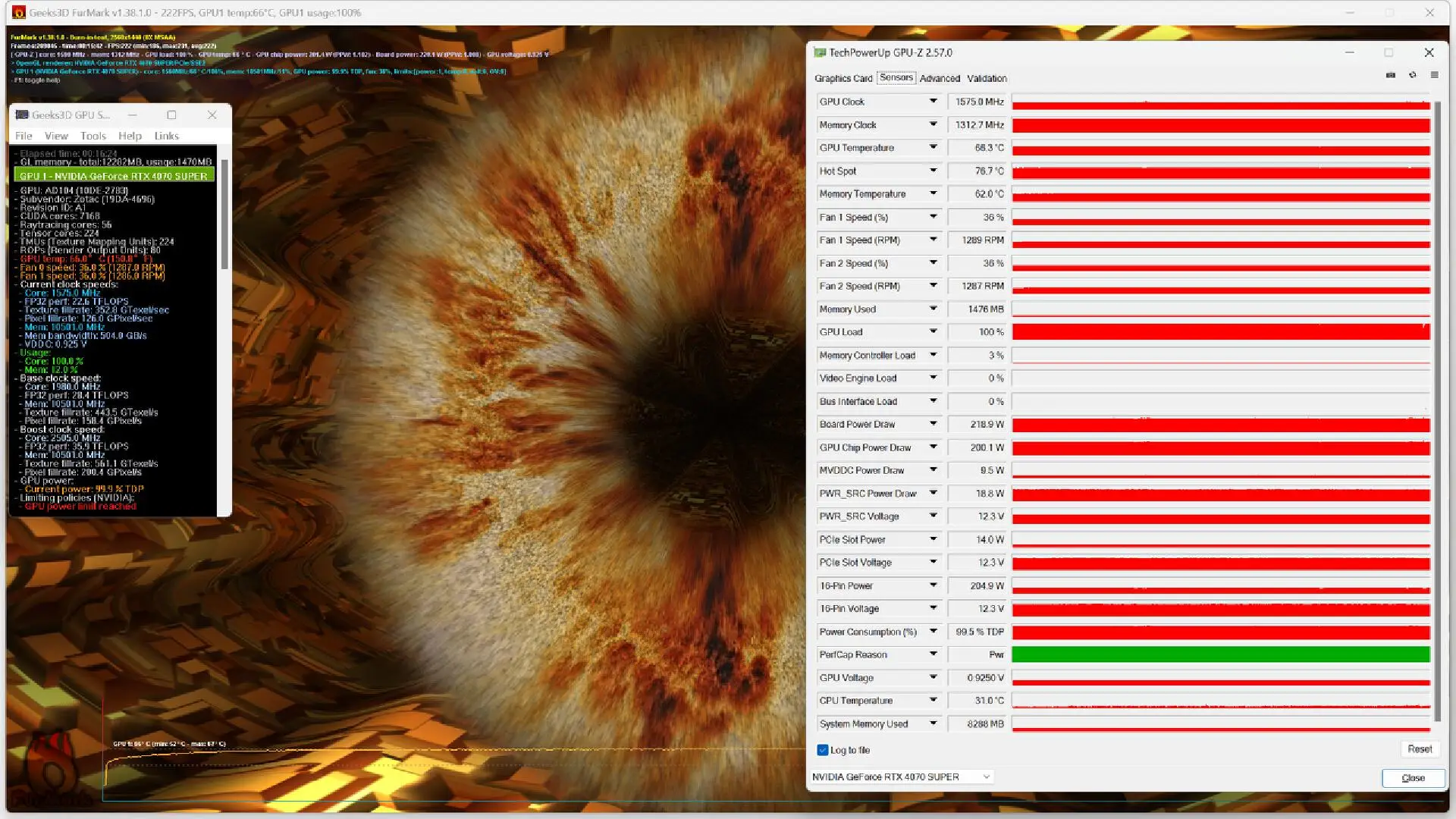

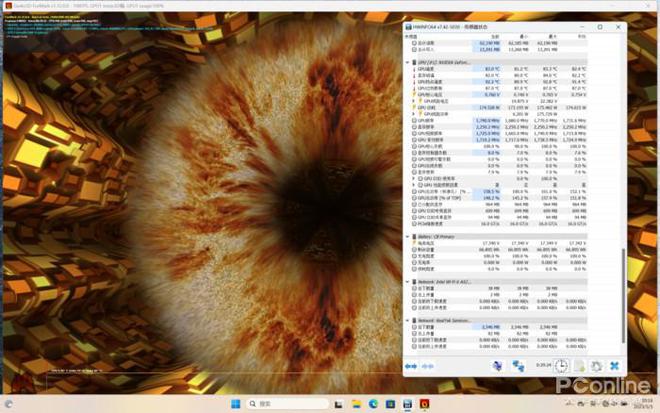

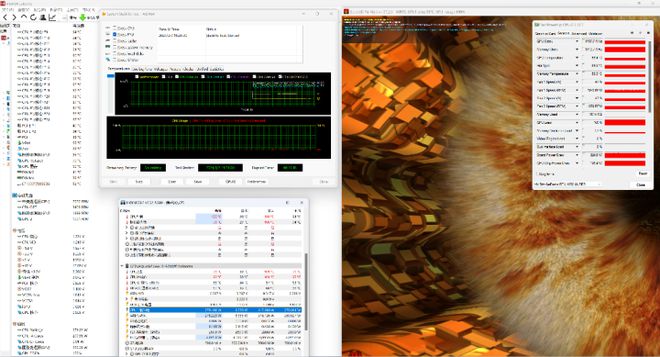

6.测试与评估GTX1050浮点性能

为全面深入地了解GTX 1050在浮点运算方面的性能表现,需展开系统性的测试和评估。有策略性地设定合理的测试场景以及运用强大的测试工具等途径,可客观公正地衡量显卡在各种作业负荷下的实际性能表现。

设计相应测试方案,针对不同性质任务(例如游戏、深度学习训练及图像处理等),搜集相关数据以供深入分析与比对。凭借测试的反馈信息,便能够掌握显卡在各个任务环境中的表现的显著差异,为用户选购更适合自身需求的电子设备提供可靠的判断标准。

开发者可通过自编测试程式及运用GPU加速库等手段对显卡进行深入分析与调优,实现性能的最大化提升。

7.未来展望与挑战

随着科学技术的持续变革及应用需求的日渐强烈,显卡在推动浮点运算领域将面临诸多挑战并孕育新的商机。据预见,未来以人工智能、虚拟现实为代表的新兴技术的飞速崛起,将极大地提升对显卡性能品质的需求。

业内企业预计将随市场潮流持续研发新产品,改进系统架构以响应市场需求;同时,开发者们也在积极寻求创新,通过提升软件效率来实现硬件潜能的最大化利用。

作为消费者,应依据个人需求甄选适宜产品,同时关注行业热点及产品升级信息,适时调整硬件配置以提升使用感受。