身为致力于深度学习及AI研究的专业人士,我深知在Ubuntu环境下合理调整GTX1060显卡及CUDA架构设置的重要性。本篇文章将详细介绍如何在Ubuntu操作系统中最大化运用GTX1060显卡优势,并且精确设定CUDA平台,以期提高深度学习运算效率。

1. GTX1060显卡概述

英伟达公司推出的GTX 1060显卡性能优越且价格适中,拥有6GB大容量显存及e85733697192f1aedadb573c8de11b7a核心与192位总线,在深度学习应用领域备受瞩目。然而,为了使其在Ubuntu操作系统中的性能达到最佳效果,仍需进行一系列细致的优化设置。

在Ubuntu系统中,最先需要执行的步骤即是为搭载GTX1060显卡的机器安装其对应的NVIDIA驱动程序。您可通过官方渠道获取最新版本的NVIDIA驱动,且需依据精心编写的指南进行繁琐却必要的安装过程。完成后,您可用nvidia-smi指令来检查显卡相关规格以及驱动版本等重要信息,以保证驱动程序已成功部署且功能完好。

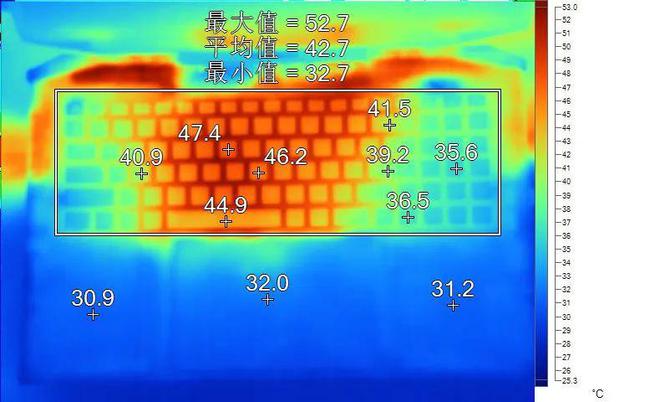

接着,我们将着重对显卡的各项性能参数加以调控,具体操作可借助NVIDIA提供的nvidia-settings软件,对搭载了GTX1060显卡的设备进行更精准的优化。调节诸如显卡频率以及散热风扇转速等关键元素完全依据实际使用需求与运行任务种类而定,力求达到理想性能表现。

另外,在采用GTX 1060开展深度学习运算过程中,严格掌控显存使用显得尤为关键。我们必须密切监视显存占用情况并杜绝内存泄漏现象,以此来提升运行效率与稳定性。

2. CUDA平台配置

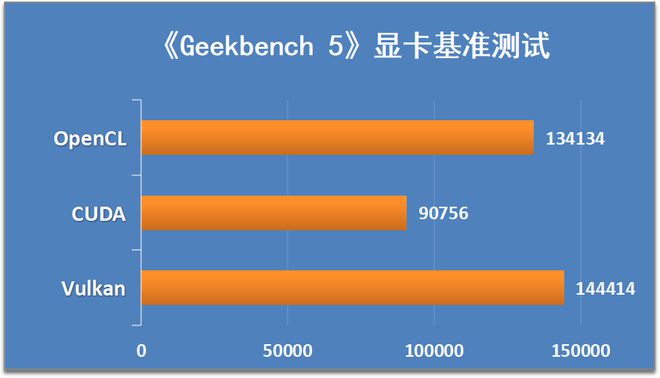

CUDA乃 NVIDIA所创的并行运算平台及编程模式,赋予开发者以GPU进行各类运算的实力。在Ubuntu环境中恰当设置CUDA平台,对深度学习工作如虎添翼。

首先,需根据自己的平台与需求,选择适合的CUDA ToolKit版次。遵循官网指引安装程序,确保适配自身系统架构。成功安装后,设定相关环境变量及路径,确保CUDA得以顺畅调用。

在开发CUDA程序中,运用GPU加速技术可显著提升运算效率。借助内置的CUDA核函数以及共享内存功能,我们得以将计算负载合理分摊至GPU上进行,从而最大程度发挥GTX 1060卓越的并行计算优势。

务必关注深度学习框架与当前CUDA版本的兼容性,选用匹配的框架,依据实际需求进行设置与调节。

3.深度学习框架与GTX1060

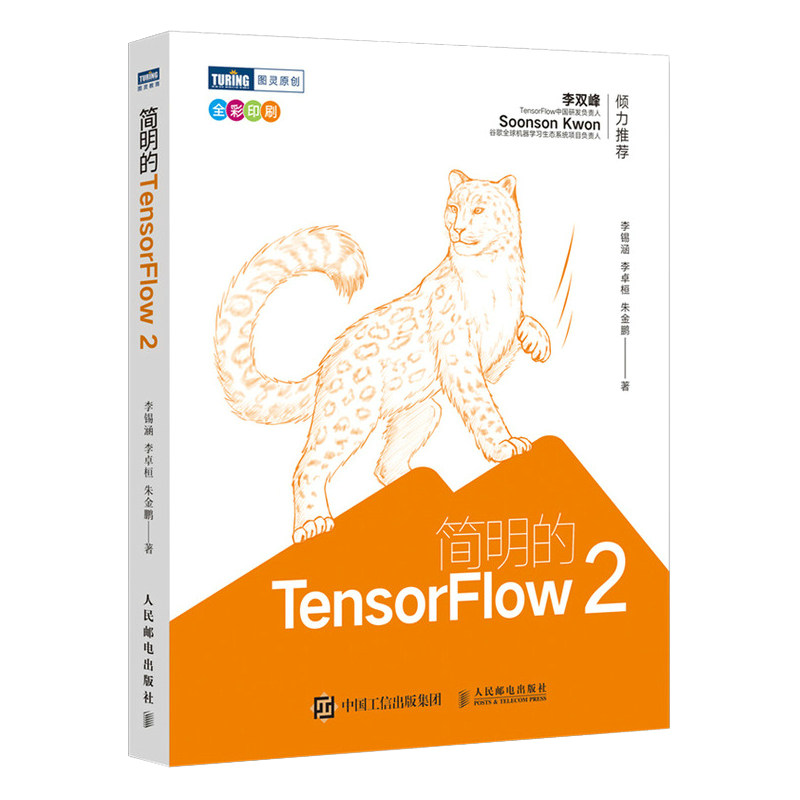

深度学习框架如TensorFlow、PyTorch等已构成深度学习任务之核心装备。对于各款框架,在Ubuntu操作系统中与GTX1060搭配应用需留意如下事项。

面对TensorFlow的使用,可通过选取适用的GPU设备、设置适当的GPU内存以更好地搭配GTX 1060显卡进行深度学习。且在应用TensorFlow过程中,指定使用哪张GPU设备以及设定合理的GPU内存分配策略也会有效提升计算速度。

相比之下,PyTorch则彰显出其具备的灵活性和易操作性,提供了高效的GPU加速能力。只需轻松地把张量移至GPU,就能完成加速运行,同时也能支持多个GPU的并行处理,发挥出GTX1060强大的性能潜能。

在Ubuntu系统中,优化GTX 1060和CUDA平台的集成以提升深度学习效率具有重要意义。通过科学地安装NVIDIA驱动程序、精准调节显卡参数、构建完整的CUDA环境,并结合使用各类深度学习框架,可使GTX 1060在深度学习领域发挥最大潜能。

4.实践案例分享

针对Ubuntu环境中GTX1060显卡和CUDA平台的优化配置,本文分享一则具体应用案例。此项目为深度学习领域的图像分类,所用操作系统为Ubuntu,采用了GTX1060显卡进行相关操作,并成功克服了实验中所遇到的难题。

初始阶段,因NVIDIA驱动的安装关联到其他程序需引用的资源,经过深入研究,逐步理清复杂的依赖关系后,最终成功安装了所需的驱动程序;二次操作中,由于CCUDA环境设定中的路径错误,导致无法正常调用CUDA库函数功能,经修正环境变量后,顺利解决此项问题。

研究中还揭示出几处潜在问题,如GPU内存释放不当引发OOM错误及批量设定不足致训练效果不佳等。经过多次试调和参数优化,在保证模型精度的基础上提升了训练效率和速率。

5.总结与展望

总的来说,Ubuntu系统中如何合理优化配置GTX 1060与CUDA平台对深度学习任务具有关键意义。安装NVIDIA驱动并有效利用CUDA加速技术,搭配合适的深度学习框架进行开发工作,每一个步骤均需仔细考虑和调整参数,从而实现最优表现。

随着硬件与软件的持续演进,我们将持续研究更优的策略与技巧以增强深度学习的算力与运行速率。希望本篇内容对正在致力于在Ubuntu系统上调整GTX 1060显卡及CUDA的诸位有所启迪,同时期盼有越来越多的同仁参与到这个领域的研究中来,共同推动这项事业发展。