身为热衷深度学习与科技研发的人士,本人对GTX 1050Ti在OpenCL环境下的潜力颇感兴趣。本文将首先概述GTX 1050Ti的详细配置,接着深入剖析其在OpenCL编程方面的独特性及适用场景,期待能给予各位技术同行们以有益的启示。

1. GTX 1050Ti概述

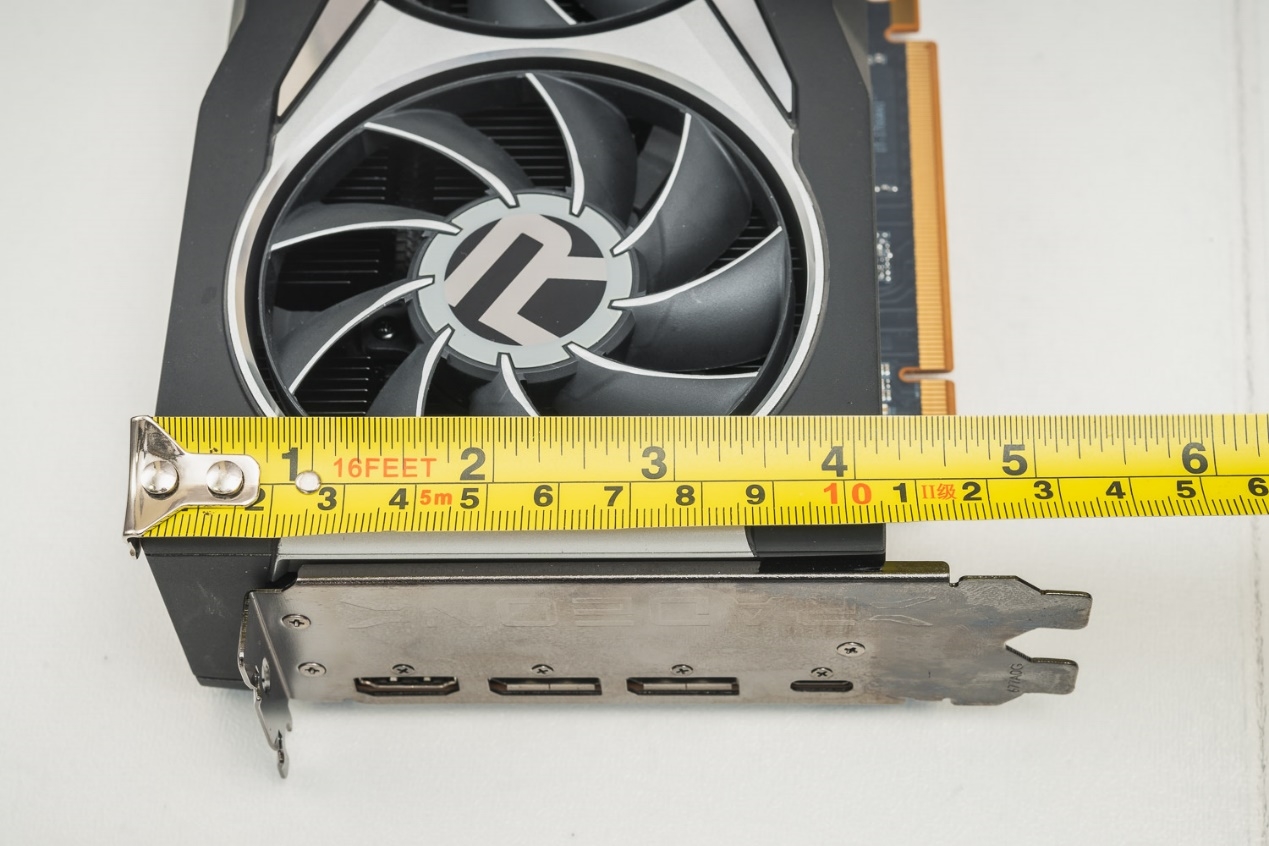

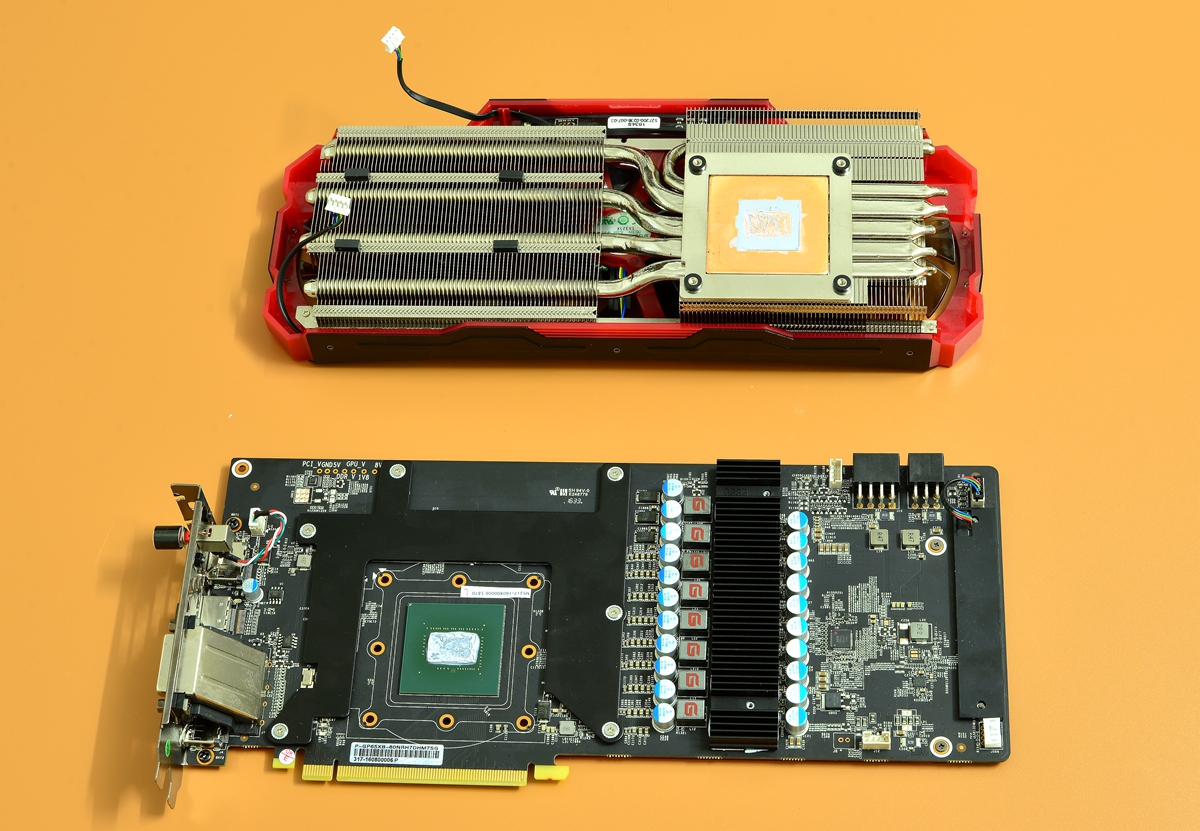

首当其冲,我们需要对搭载Pascal架构,配备4GB GDDR5显存以及768个CUDA核心的GTX 1050Ti有一较全面的了解。作为NVIDIA旗下一款专注面向中低端市场的显卡产品,尽管它无法与高端设备相媲美,但是以其卓越的性价比优势,尤其适用于广大游戏爱好者以及轻量级工作负载使用者。

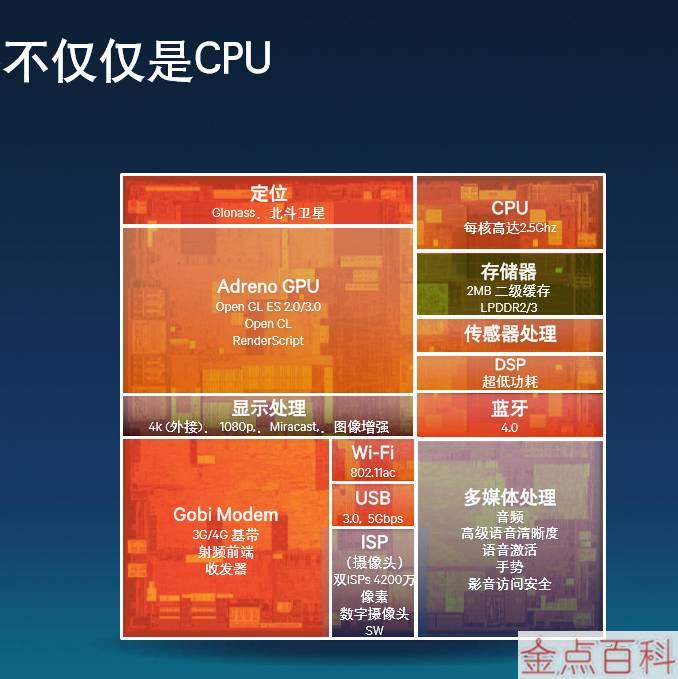

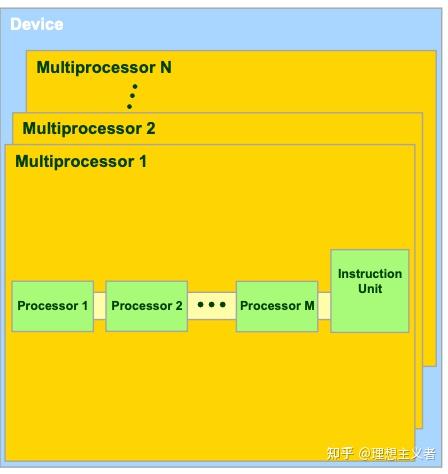

2. OpenCL简介

OpenCL,即开源计算语言,作为可跨多平台的平行计算框架,其目标在于为通用方案提供并行编程服务。该格式兼容混合计算环境,其中涵盖了CPU、GPU、FPGA等多种设备,从而充分利用这些设备各自的并行计算优势。值得注意的是,在深度学习、科学计算和图像处理等众多领域,OpenCL都显示出广阔的应用潜力。

3. GTX 1050Ti在OpenCL中的优势

GTX 1050Ti,作为一款中档性能显卡,在OpenCL编程领域也具有以下显著特点:首先,凭借其优越的性价比,为广大开发人员提供了经济实惠的并行运算选择;其次,在小型数据集处理方面表现卓越,尤其适宜应对轻量级计算需求;再者,在能耗调控方面同样表现优秀,实现节能环保。

4. GTX 1050Ti在科学计算中的应用

在科学计算领域,NVIDIA GeForce GTX 1050 Ti的卓越性能尤为重要。在天文学领域中,它能有效探索星系模型和宇宙演化等复杂科研问题;在生物信息学方面,GTX 1050 Ti成功完成了基因组解析、蛋白结构预判等多项科研任务;最后,随着地球科学研究的不断深入,气候模拟与地质探测等相关工作也离不开它的支持。总而言之,鉴于其强大的并行运算能力以及性价比较高的优势,GTX 1050 Ti已然成为了众多科研工作者普遍使用的重要工具。

5. GTX 1050Ti在深度学习中的应用

深度学习乃近期引人瞩目的人工智能技术,尤其在图像识别的准确度和自然语言理解的准确性上,有着出色表现。借助配备有CUDA加速功能的GPU卡——GTX 1050Ti,在深度学习模型训练方面同样具备良好表现。运用灵活且高效的OpenCL框架进行并行运算,该过程无疑极大地缩短了神经网络模型训练时间,进一步提升了整体训练效率。

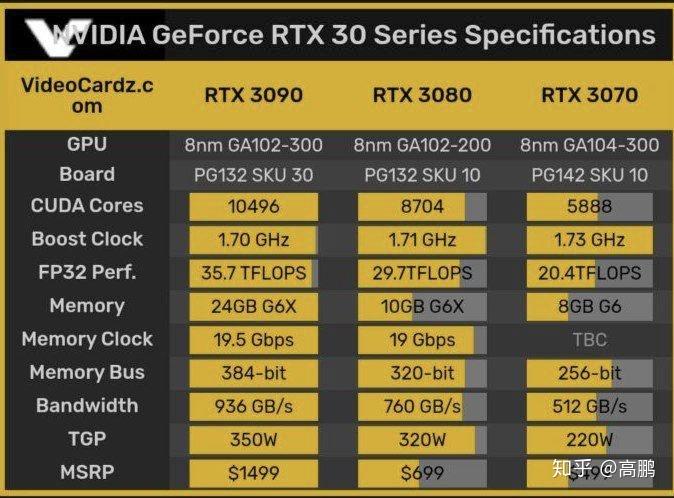

6. GTX 1050Ti与其他显卡在OpenCL性能对比

除了GTX 1050 Ti之外,市场上众多其他显卡也支持OpenCL编程,为用户提供多元化选择,以应对不同需求与预算。利用不同显卡在OpenCL性能上的表现统计数据进行比较分析,可为项目筛选合适的硬件设备提供依据。

7. OpenCL编程实践案例分享

在此,本文将以实例形式探讨Geforce GTX 1050 Ti在CPU OpenCL编程方面的应用。一支科研团队借助此显卡卓越性能显著提升了图像处理效率。通过优化算法与并行计算,他们既确保了图像质量又大幅度地缩短了处理时间。这一成功案例充分证明了GTX 1050 Ti于实际生产环境中的可行及有效性,同时激发引领更多开发人员积极探索使用此款强大硬件执行创新性任务。